Abstract

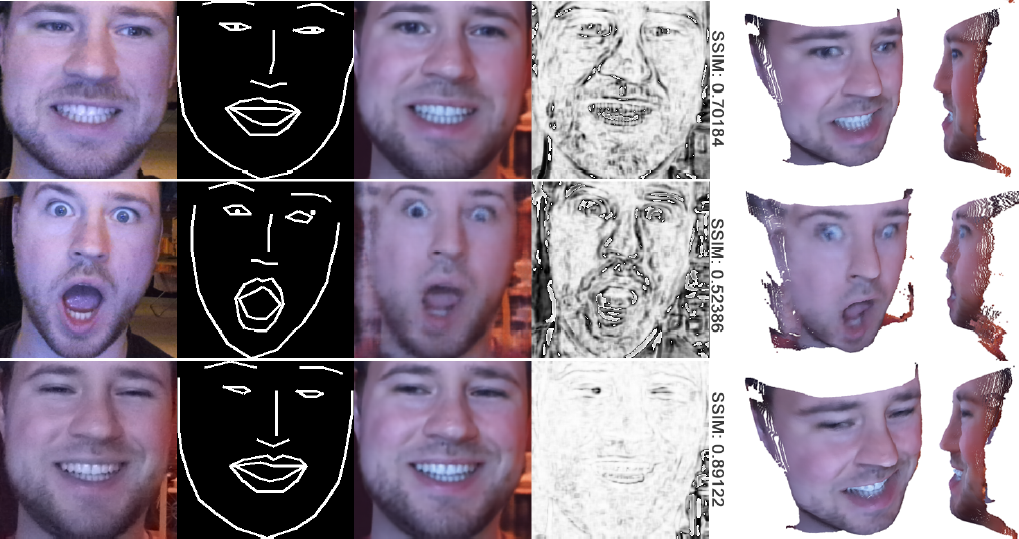

Es existiert derzeit keine Lösung für eine Face-to-Face-Konversation in Virtual Reality (VR), bei der die Teilnehmer Head-mounted-Displays (HMDs) tragen. Die Herausforderung besteht darin, dass das Gesicht der Teilnehmer zu einem signifikanten Teil verdeckt ist und bewährte Technologien zur Gesichtserfassung nicht eingesetzt werden können. Wir stellen ein Teilsystem vor, das auf dem Weg zu dreidimensionalen immersiven Telepräsenzanwendungen das Verdeckungsproblem durch HMDs lösen könnte. Das System nutzt preiswerte Bauteile, eine gängige RGBD-Kamera für die Aufnahme sowie mehrere Verfahren aus dem Bereich der künstlichen Intelligenz. Wir lernen mit einem Generative Adversarial Network (GAN) die individuelle Beschaffenheit und Mimik des Gesichtes einer Person und rekonstruieren diese mit VR-fähigen Bildwiederholfrequenzen. Dabei erweitern wir das Konzept der Pix2Pix-GAN-Architektur nach Isola et al. um die dritte Dimension und Rendern das Ergebnis als texturierte Punktwolke. Wir nennen unser Konzept RGBD-FaceAvatar-GAN und stellen den Code frei zur Verfügung. Der Fokus der Arbeit liegt auf der softwareseitigen Rekonstruktion des Gesichtes, jedoch nicht auf dem Bau oder der Umsetzung eines Sensor-HMDs, das die Mimik einer nutzenden Person erkennt.